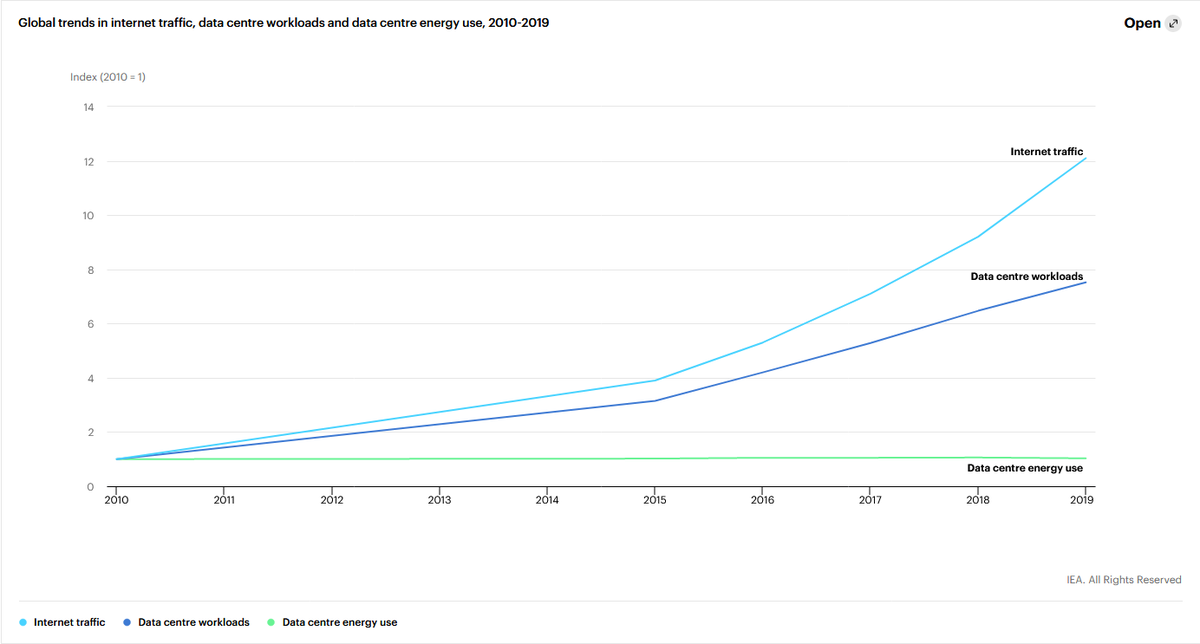

La consommation des serveurs n& #39;a pas augmenté depuis 2010. J& #39;en reviens toujours pas. Vous en pensez quoi ? (source : IEA)

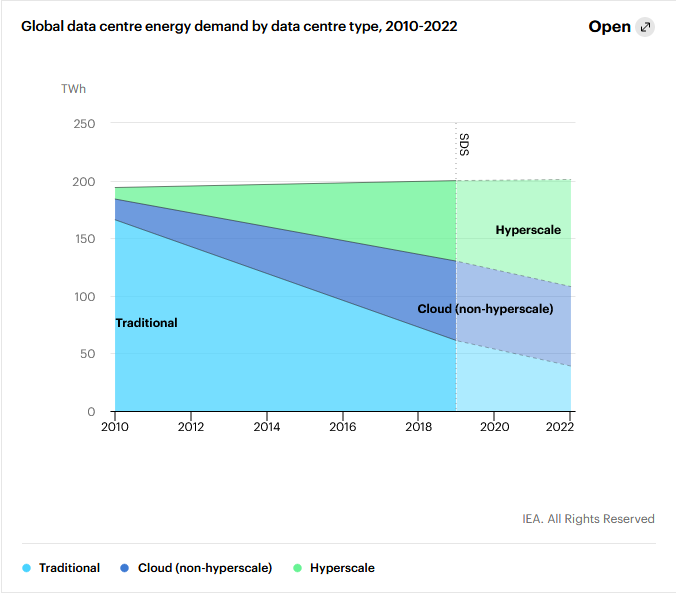

L& #39;explication viendrait de l& #39;optimisation de bourrin (parce que la niveau optimisation c& #39;est du haut level) du notamment à l& #39;hyperscale computing.

Ça remet complètement en question ma position sur le cloud niveau énergie. Je lis par-ci par la qu& #39;il faudrait éviter le cloud et travailler un max en local. Mais finalement ça serait plus pour réduire l& #39;usage du réseau (qui consomme pas mal, il faut que je trouve les chiffres)

Que charge serveur qui a l& #39;air d’être bien plus opti qu& #39;une machine en local même si elle est pas tout le temps allumée. Il faudrait que je creuse ça.

Lien vers la source : https://www.iea.org/reports/data-centres-and-data-transmission-networks">https://www.iea.org/reports/d...

Read on Twitter

Read on Twitter