1/

[THREAD]

Aujourd& #39;hui, la p-value !

(parce qu& #39;on m& #39;a un peu cherché avec ça...).

Cette histoire de "résultats significatifs", de "graal" des études ?

On l& #39;utilise partout, parfois sans savoir, même certains chercheurs.

(spoil : va y avoir la grande citation du Raoult)

[THREAD]

Aujourd& #39;hui, la p-value !

(parce qu& #39;on m& #39;a un peu cherché avec ça...).

Cette histoire de "résultats significatifs", de "graal" des études ?

On l& #39;utilise partout, parfois sans savoir, même certains chercheurs.

(spoil : va y avoir la grande citation du Raoult)

2/

Si je lance une pièce 4 fois et que je tombe 3 fois sur pile, est-ce qu& #39;elle est truquée ? Réponse : peut-être, on sait pas.

Si je lance une pièce 4000 fois et que je tombe 3000 fois sur pile, est-ce qu& #39;elle est truquée ? Réponse : c& #39;est pas certain, mais presque.

Si je lance une pièce 4 fois et que je tombe 3 fois sur pile, est-ce qu& #39;elle est truquée ? Réponse : peut-être, on sait pas.

Si je lance une pièce 4000 fois et que je tombe 3000 fois sur pile, est-ce qu& #39;elle est truquée ? Réponse : c& #39;est pas certain, mais presque.

3/

Donc en sciences expérimentales, on ne peut jamais être certain à 100%, mais il y a moyen de quantifier cette incertitude. C& #39;est un peu ça, la p-value: une probabilité de se gourrer (pour les puristes, je préfère expliquer ainsi plutôt qu& #39;en H0 et H1 : précisez si vous voulez)

Donc en sciences expérimentales, on ne peut jamais être certain à 100%, mais il y a moyen de quantifier cette incertitude. C& #39;est un peu ça, la p-value: une probabilité de se gourrer (pour les puristes, je préfère expliquer ainsi plutôt qu& #39;en H0 et H1 : précisez si vous voulez)

4/

Plus la p-value est faible, plus la certitude est forte. Mais il n& #39;y a pas de "seuil" naturel. Il faut donc en choisir un quand même (car on ne va pas s& #39;amuser à lancer la pièce de monnaie une infinité de fois, ou on ne va pas tester un traitement sur 6 milliards de patients).

Plus la p-value est faible, plus la certitude est forte. Mais il n& #39;y a pas de "seuil" naturel. Il faut donc en choisir un quand même (car on ne va pas s& #39;amuser à lancer la pièce de monnaie une infinité de fois, ou on ne va pas tester un traitement sur 6 milliards de patients).

5/

En sciences on fixe souvent ce seuil à 5% se chances de se tromper. C& #39;est arbitraire. En physique des particules, ils sont beaucoup plus exigeants. Ce seuil est devenu un truc trop fort à mon goût (4,95% : je publie, 5,05% : je publie pas, c& #39;est un peu débile). Grand débat.

En sciences on fixe souvent ce seuil à 5% se chances de se tromper. C& #39;est arbitraire. En physique des particules, ils sont beaucoup plus exigeants. Ce seuil est devenu un truc trop fort à mon goût (4,95% : je publie, 5,05% : je publie pas, c& #39;est un peu débile). Grand débat.

6/

On peut cependant recalculer la p-value à chaque fois qu& #39;on répète une nouvelle fois l& #39;expérience (ou qu& #39;on inclut un nouveau patient) : ça permet de visualiser la variation de p-value ("fonction de puissance", trop rarement fournie) et de voir si elle atteint un certain seuil

On peut cependant recalculer la p-value à chaque fois qu& #39;on répète une nouvelle fois l& #39;expérience (ou qu& #39;on inclut un nouveau patient) : ça permet de visualiser la variation de p-value ("fonction de puissance", trop rarement fournie) et de voir si elle atteint un certain seuil

7/

On en vient à la citation du Raoult "c& #39;est contre-intuitif mais moins il y a de patients, plus les résultats sont significatifs". Evidemment non. Mais il s& #39;est repris en disant : "moins il y a de patients, plus quand les résultats sont significatifs, c& #39;est significatif". Ah...

On en vient à la citation du Raoult "c& #39;est contre-intuitif mais moins il y a de patients, plus les résultats sont significatifs". Evidemment non. Mais il s& #39;est repris en disant : "moins il y a de patients, plus quand les résultats sont significatifs, c& #39;est significatif". Ah...

8/

En fait, ce qu& #39;il voulait dire, c& #39;est que si on a besoin de beaucoup de patients pour arriver à une p-value significative, c& #39;est que l& #39;EFFET est faible. Pas besoin d& #39;être allé au-delà de la 3ème, mais bon...

En fait, ce qu& #39;il voulait dire, c& #39;est que si on a besoin de beaucoup de patients pour arriver à une p-value significative, c& #39;est que l& #39;EFFET est faible. Pas besoin d& #39;être allé au-delà de la 3ème, mais bon...

9/

Ce point est très important : on peut avoir un EFFET fort mais très incertain, et un EFFET faible mais presque CERTAIN. toujours regarder la taille d& #39;effet, et pas seulement la p-value.

Ce point est très important : on peut avoir un EFFET fort mais très incertain, et un EFFET faible mais presque CERTAIN. toujours regarder la taille d& #39;effet, et pas seulement la p-value.

10/

C& #39;est pour ça que quand les résultats d& #39;une étude clinique se font attendre, ça veut dire que l& #39;effet est faible ou nul (on ne peut pas le savoir à l& #39;avance) et donc qu& #39;il faut inclure davantage de patients pour être sûr du résultat (avoir une bonne p-value). Ex : Discovery.

C& #39;est pour ça que quand les résultats d& #39;une étude clinique se font attendre, ça veut dire que l& #39;effet est faible ou nul (on ne peut pas le savoir à l& #39;avance) et donc qu& #39;il faut inclure davantage de patients pour être sûr du résultat (avoir une bonne p-value). Ex : Discovery.

11/

Comme la p-value est devenue le "graal", certains cherchent après-coup là où elle est "significative". Sauf qu& #39;en multipliant cela vous finirez toujours par trouver un truc qui semble significatif : c& #39;est le p-hacking. Or même au seuil de 5% il y a une chance se de se gourrer

Comme la p-value est devenue le "graal", certains cherchent après-coup là où elle est "significative". Sauf qu& #39;en multipliant cela vous finirez toujours par trouver un truc qui semble significatif : c& #39;est le p-hacking. Or même au seuil de 5% il y a une chance se de se gourrer

12/

Raison pour laquelle on se méfie quand une étude change son critère de réussite en cours de route, ou quand on analyse les données en sous-groupes après-coup (spéciale dédicace à France-Soir...). DANGER : gros biais de confirmation.

Raison pour laquelle on se méfie quand une étude change son critère de réussite en cours de route, ou quand on analyse les données en sous-groupes après-coup (spéciale dédicace à France-Soir...). DANGER : gros biais de confirmation.

13/

Enfin, un truc que même beaucoup de chercheurs n& #39;ont pas compris : la p-value ne mesure pas le % de chances que la théorie soit vraie, mais elle mesure le % de chances que si la théorie est vraie alors les données collent à la théorie. Ca vous parait fumeux ?

Enfin, un truc que même beaucoup de chercheurs n& #39;ont pas compris : la p-value ne mesure pas le % de chances que la théorie soit vraie, mais elle mesure le % de chances que si la théorie est vraie alors les données collent à la théorie. Ca vous parait fumeux ?

14/

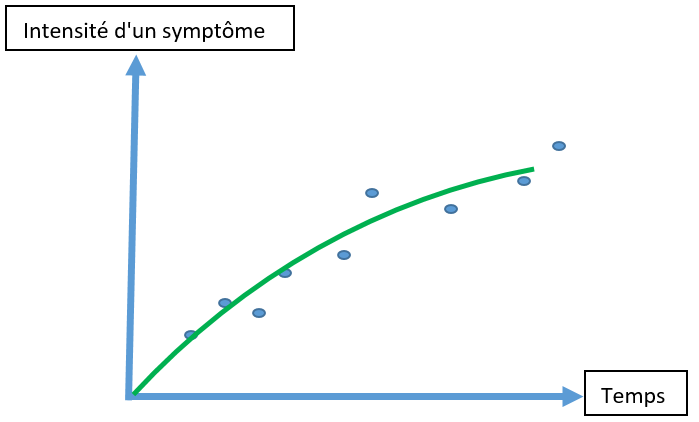

Prenons un exemple. Vous testez l& #39;évolution d& #39;une maladie chez des patients. Votre p-value est bonne : a priori votre hypothèse d& #39;évolution linéaire de la maladie est bonne (la droite, en rouge)

Prenons un exemple. Vous testez l& #39;évolution d& #39;une maladie chez des patients. Votre p-value est bonne : a priori votre hypothèse d& #39;évolution linéaire de la maladie est bonne (la droite, en rouge)

15/

Sauf que cette hypothèse-là : évolution de la maladie qui se stabilise (la courbe, en vert) vous donnerait une p-value tout aussi bonne. Mais les conclusions sont radicalement différentes !

Sauf que cette hypothèse-là : évolution de la maladie qui se stabilise (la courbe, en vert) vous donnerait une p-value tout aussi bonne. Mais les conclusions sont radicalement différentes !

16/

Alors vous me direz : "j& #39;aime mieux la courbe verte". Sauf que non car besoin de davantage de "paramètres de réglage". Or sans données indépendantes permettant de justifier ces paramètres, on prend l& #39;hypothèse la plus simple. Ici, il faut s& #39;en tenir à la droite rouge.

Alors vous me direz : "j& #39;aime mieux la courbe verte". Sauf que non car besoin de davantage de "paramètres de réglage". Or sans données indépendantes permettant de justifier ces paramètres, on prend l& #39;hypothèse la plus simple. Ici, il faut s& #39;en tenir à la droite rouge.

17/

Moralité. 1) regarder d& #39;abord la taille de l& #39;EFFET. 2) Toujours regarder le nuage de points si c& #39;est du quantitatif. 3 ) Et dans ce cas: d& #39;abord le r², puis l& #39;erreur standard des résidus, puis la p-value. Et la p-value est importante mais ne lui faites pas dire n& #39;importe quoi

Moralité. 1) regarder d& #39;abord la taille de l& #39;EFFET. 2) Toujours regarder le nuage de points si c& #39;est du quantitatif. 3 ) Et dans ce cas: d& #39;abord le r², puis l& #39;erreur standard des résidus, puis la p-value. Et la p-value est importante mais ne lui faites pas dire n& #39;importe quoi

18/

Comme toujours, je suis pas une "star mondiale" (comme certains...) : précisez, corrigez, tapez dessus... @Juni8T , @T_Fiolet , @Damkyan_Omega et les autres...

Comme toujours, je suis pas une "star mondiale" (comme certains...) : précisez, corrigez, tapez dessus... @Juni8T , @T_Fiolet , @Damkyan_Omega et les autres...

19/ (ajout)

J& #39;ai oublié de dire : avec le seuil classique de p-value de 5%, c& #39;est égal à 1/20, donc 1 chance sur 20 de se tromper, donc en moyenne 1 étude sur 20 qui se "tromperait". Donc ne pas "brandir" une seule étude en oubliant les autres (homéopathie?...). Recouper l& #39;info.

J& #39;ai oublié de dire : avec le seuil classique de p-value de 5%, c& #39;est égal à 1/20, donc 1 chance sur 20 de se tromper, donc en moyenne 1 étude sur 20 qui se "tromperait". Donc ne pas "brandir" une seule étude en oubliant les autres (homéopathie?...). Recouper l& #39;info.

20/ (ajout)

Bravo pour vos remarques: contrairement à ce que j& #39;ai écrit, la p-value n& #39;est pas vraiment la "probabilité de se gourer". Je le sais mais c& #39;est dur de faire tenir en un tweet. Mais j& #39;ai précisé les choses en parties 13-14-15 + VOS REPONSES UTILES: à lire. Merci à tous

Bravo pour vos remarques: contrairement à ce que j& #39;ai écrit, la p-value n& #39;est pas vraiment la "probabilité de se gourer". Je le sais mais c& #39;est dur de faire tenir en un tweet. Mais j& #39;ai précisé les choses en parties 13-14-15 + VOS REPONSES UTILES: à lire. Merci à tous

21/ (ajout)

On me fait remarquer : erreur en partie 6/

On ne recalcule pas la p-value à chaque nouveau patient jusqu& #39;à tomber pile à la bonne p-value, car ce serait du raisonnement biaisé (en gros : attendre le "bon" patient). (j& #39;espère avoir pigé). Merci pour la précision !

On me fait remarquer : erreur en partie 6/

On ne recalcule pas la p-value à chaque nouveau patient jusqu& #39;à tomber pile à la bonne p-value, car ce serait du raisonnement biaisé (en gros : attendre le "bon" patient). (j& #39;espère avoir pigé). Merci pour la précision !

22/ (ajout)

Eh ben y a du succès https://abs.twimg.com/emoji/v2/... draggable="false" alt="🥳" title="Partying face" aria-label="Emoji: Partying face">

https://abs.twimg.com/emoji/v2/... draggable="false" alt="🥳" title="Partying face" aria-label="Emoji: Partying face">

Faut m& #39;excuser si j& #39;ai plus le temps de répondre à tout le monde : vos remarques ou questions sont hyper-intéressantes https://abs.twimg.com/emoji/v2/... draggable="false" alt="👍" title="Thumbs up" aria-label="Emoji: Thumbs up">. Souvent, vous trouverez les réponses dans... les réponses à chaque partie: beaucoup y ont apporté de précieuses précisions.

https://abs.twimg.com/emoji/v2/... draggable="false" alt="👍" title="Thumbs up" aria-label="Emoji: Thumbs up">. Souvent, vous trouverez les réponses dans... les réponses à chaque partie: beaucoup y ont apporté de précieuses précisions.

Eh ben y a du succès

Faut m& #39;excuser si j& #39;ai plus le temps de répondre à tout le monde : vos remarques ou questions sont hyper-intéressantes

23/ (ajout)

Bel article qu& #39;on m& #39;a transmis :

https://link.springer.com/article/10.1007/s10654-016-0149-3

(copiez-collez">https://link.springer.com/article/1... dans Google traduction si ça vous chante)

Et pour les néophytes curieux de comprendre, les vidéos sur ce sujet de "La statistique expliquée à mon chat", "Science Etonnante", "Hygiène Mentale"...

Bel article qu& #39;on m& #39;a transmis :

https://link.springer.com/article/10.1007/s10654-016-0149-3

(copiez-collez">https://link.springer.com/article/1... dans Google traduction si ça vous chante)

Et pour les néophytes curieux de comprendre, les vidéos sur ce sujet de "La statistique expliquée à mon chat", "Science Etonnante", "Hygiène Mentale"...

@threadreaderapp unroll

Read on Twitter

Read on Twitter